Devant la prolifération des deepfakes en temps réel, une entreprise a déterminé deux méthodes simples pour savoir si votre interlocuteur est bien celui qu’il prétend être. Demandez-lui tout simplement de passer sa main devant son visage ou de se mettre de profil.

La qualité des deepfakes évolue à une vitesse folle et les résultats sont de plus en plus convaincants. Au mois de mars un faux président Zelensky a annoncé la capitulation de l’Ukraine. Ce genre de vidéo est préparé à l’avance avec des heures de traitement. Toutefois, il existe désormais des algorithmes qui fonctionnent en temps réel et qui permettent de changer de tête pendant un appel en visio.

Fin juin, le FBI signalait que certains malfaiteurs utilisent cette technologie afin de passer des entretiens d’embauche pour des postes en télétravail. Ils obtiennent ainsi accès à des informations protégées des entreprises sans jamais dévoiler leur vraie identité. Des spécialistes en intelligence artificielle de l’entreprise Metaphysic se sont penchés sur la question et ont découvert deux méthodes simples pour savoir si un correspondant utilise un logiciel de deepfake pendant un appel.

LES ALGORITHMES DE DEEPFAKE NE PARVIENNENT PAS À PRODUIRE UNE IMAGE CORRECTE LORSQUE LA TÊTE EST TOURNÉE À 90 DEGRÉS.

Tourner la tête ou passer sa main devant son visage suffit à rompre l’illusion

La première consiste à lui demander de passer sa main devant son visage. Le logiciel devra tenter de superposer l’image réelle de la main sur l’image du visage qu’il a générée. Pendant que l’algorithme essaie de compenser, cela crée une latence et des artéfacts visuels, comme des doigts qui disparaissent… Selon Metaphysic, les avancées dans le domaine de l’IA devraient toutefois permettre de compenser ce genre de problème dans un avenir proche.

La seconde méthode, et la plus fiable selon les spécialistes, est de jouer sur l’angle du visage. Au mois de mai, un deepfake en temps réel avait réussi à tromper un système de « détection du vivant » (liveness detector), une IA utilisée notamment par les banques pour les systèmes d’identification biométrique. Elle s’assure que la personne est bien un être humain, et non un faux. Mais dans ce cas précis, le système n’avait pas demandé à la personne de tourner la tête.

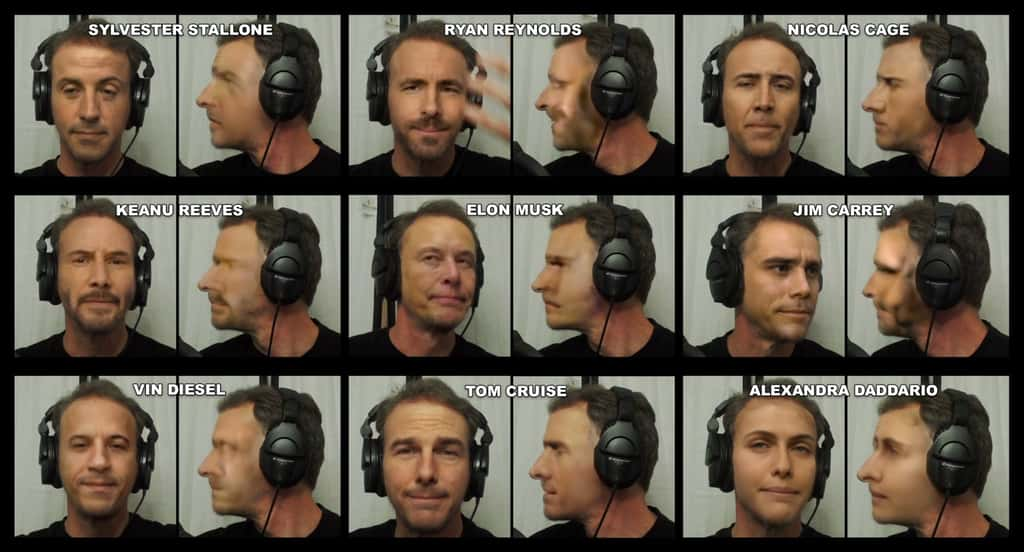

Les algorithmes de deepfake sont conçus pour fonctionner de face. Il suffit donc de demander à son interlocuteur de tourner la tête sur le côté pour voir apparaître des erreurs et le profil de la personne qui se cache derrière le deepfake. Mais attention, dans certains cas, les logiciels peuvent afficher des images plausibles jusqu’à un angle de 80 degrés. Il faut donc que la personne tourne sa tête à un angle de 90 degrés par rapport à la caméra.

DES EXEMPLES DE DEEPFAKES AVEC DES CÉLÉBRITÉS GRÂCE AU LOGICIEL DEEPFACELIVE, CRÉDIBLES SAUF À UN ANGLE DE 90 DEGRÉS.

Des erreurs difficiles à corriger en l’absence de photos prises de profil

La technologie pourrait évoluer pour tenter de corriger cette lacune, mais elle manquera toujours de données pour un résultat parfait. Pour les célébrités, il existe généralement de nombreux clichés et vidéos sous tous les angles et il est donc tout à fait concevable que les deepfakes en temps réel pourraient éliminer les erreurs en utilisant leurs visages.

Néanmoins, en dehors des personnes connues, peu de gens ont des photos prises de profil. Même avec une vidéo en haute définition partagée sur les réseaux sociaux, il est peu probable que l’IA puisse y trouver assez de matière pour créer un deepfake parfait, et notamment avec différentes expressions du visage.

Peut-être que la prochaine arnaque sera de faux entretiens d’embauche où un faux employeur vous demandera de tourner la tête pour prouver que vous êtes réel, tout en enregistrant votre image de profil pour la réutiliser plus tard dans un deepfake…

yahoo