Alors que Nvidia détient au moins 80 % du marché mondial des puces d’intelligence artificielle, la multinationale américaine a annoncé lundi la sortie d’une nouvelle « superpuce ». La puce B200, présentée comme encore plus puissante que la précédente (H100), devrait notamment permettre d’entraîner des modèles plus complexes ou encore d’accélérer le temps de prédiction de ChatGPT et consorts. Ainsi que de conforter le « quasi-monopole » de Nvidia dans ce secteur de la tech.

Déjà un acteur incontournable du secteur de l’intelligence artificielle, Nvidia a encore envoyé un message fort à la concurrence. La multinationale américaine spécialiste des semi-conducteurs a annoncé, lundi 18 mars, la sortie de sa nouvelle « superpuce » destinée à accompagner la révolution de l’intelligence artificielle (IA).

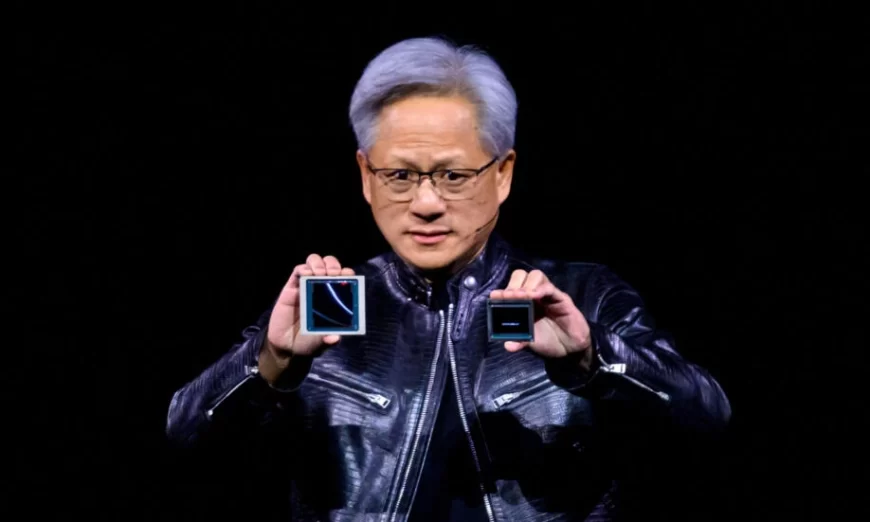

Dans un moment où Nvidia cherche à consolider sa position mondiale de fournisseur crucial – elle détient au moins 80 % du marché mondial des puces consacrées à l’IA -, son directeur général Jensen Huang a présenté la puce Blackwell B200 lors d’une conférence pour les développeurs à San Jose (Californie).

Nommée ainsi en hommage à David Harold Blackwell, le premier universitaire afro-américain entré à la National Academy of Sciences, cette technologie doit fournir pour l’IA des « superpuces » quatre fois plus rapides que celles de la génération précédente ayant servi à entraîner les modèles d’IA existants, selon Nvidia.

« Cette nouvelle puce affiche des performances impressionnantes avec une puissance de calcul qui continue de croître exponentiellement », relève Fabrice Popineau, spécialiste de l’IA et enseignant-chercheur à la CentraleSupélec université Paris-Saclay.

Pour Raphaël-David Lasseri, expert numérique, docteur en physique nucléaire théorique et fondateur de Magic LEMP, cette présentation de la multinationale américaine devrait entraîner une accélération du développement des IA existantes : « Ce qu’a annoncé Nvidia, c’est globalement un facteur cinq d’accélération de la puissance de calcul de l’entraînement des modèles », explique-t-il.

« Cela va permettre à la fois d’accélérer énormément les entraînements de modèles (d’IA, NDLR) et de réduire le nombre de puces nécessaires pour les entraîner. Et ainsi d’avoir des modèles de plus en plus gros, et donc de plus en plus puissants. »

« Vitesse de prédiction plus rapide » et IA multimédias

L’arrivée de la puce B200 semble, en effet, prometteuse pour la poursuite du développement des modèles d’IA – auxquels Nvidia a déjà apporté une contribution conséquente ces dernières années. Avec sa puce H100 sortie en 2022, la multinationale américaine s’est rendue indispensable au secteur de la tech, notamment des Gafam qui s’arrachent sa technologie à 37 000 euros pièce.

Des H100 tellement recherchées qu’elles faisaient dire à Elon Musk en 2023 qu’elles « sont plus difficiles à trouver que de la drogue ». Meta – le propriétaire de Facebook -, Microsoft, Google ou encore Amazon font partie des plus gros clients de Nvidia pour ces puces dédiées à l’IA.

Les mêmes acteurs, ainsi qu’OpenAI et Tesla, devraient aussi utiliser la B200 à l’avenir, selon Nvidia.

Avec ses 80 milliards de transistors (des composants électroniques essentiels au fonctionnement d’une puce), la H100 a permis aux modèles d’IA d’être entraînés neuf fois plus rapidement que la moyenne. La puce B200 et ses 208 milliards de transistors vont encore accélérer la dynamique, et peut-être amorcer une nouvelle génération d’IA.

« Cette nouvelle technologie va notamment se concrétiser par une vitesse de prédiction plus rapide des modèles d’IA », explique Raphaël-David Lasseri.

« La version de GPT-4, par exemple, met du temps à prédire et avec ce qui a été annoncé par Nvidia – même si ce chiffre est à prendre avec des pincettes – cela pourrait amener une accélération de 30 fois la vitesse de prédiction. Donc cela veut dire aller beaucoup plus vite, et aussi servir plus d’utilisateurs en même temps avec moins de puces. »

Le spécialiste de l’IA estime aussi que cette nouvelle puce devrait permettre de « réduire le temps de latence (le délai entre une action et le déclenchement d’une réaction, NDLR) et ainsi permettre des applications beaucoup plus naturelles en termes conversationnels. »

Les capacités supérieures de la B200 par rapport à la H100 devraient aussi permettre l’essor des IA générant des éléments multimédias – gourmands en puissance de calcul -, que ce soit pour de l’audio, de l’image (comme Midjourney, qui crée des images à partir de texte) ou encore de la vidéo (comme Sora, qui crée des vidéos à partir de texte). « On peut effectivement espérer que ces modèles d’IA soient plus performants avec ces nouvelles puces », selon Fabrice Popineau.

« Dans cette ruée vers l’or, Nvidia vend les pelles »

Nvidia regarde déjà vers l’avenir de l’IA et semble pour le moment laisser la concurrence au bord de la route : alors que la multinationale fait la promotion d’une nouvelle puce encore plus puissante, ses rivaux – dont Intel, AMD, Micron ou encore Texas Instruments – restent encore à la peine pour faire jeu égal avec la puissance et l’efficacité du H100 sorti depuis deux ans.

De quoi donner encore une longueur d’avance au spécialiste américain des semi-conducteurs.

« Nvidia est déjà dans une situation de quasi-monopole dans le secteur de l’IA », selon Raphaël-David Lasseri, qui illustre cette hégémonie par une métaphore : « Dans cette ruée vers l’or, Nvidia vend les pelles et est pour l’instant le seul vendeur crédible de la planète. »

Et la vente de pelles rapporte gros à la firme américaine : cette position de premier plan a propulsé l’action de Nvidia vers des sommets boursiers, avec environ +250 % sur un an et même +80 % depuis début 2024. Le groupe de Santa Clara est passé devant Amazon en matière de capitalisation boursière, arrivant juste derrière Microsoft et Apple. Il a même franchi le seuil symbolique de 2 000 milliards de dollars de valorisation le 23 février.

Une situation que n’avaient connu que Microsoft, Apple et le pétrolier Saudi Aramco avant lui.

Et la mise en vente des puces B200 ne devrait que conforter sa place de leader du secteur. Après la présentation de lundi, Kinngai Chan, directeur exécutif et analyste senior chez Summit Insights, a estimé qu’avec « le lancement de Blackwell (…) Nvidia va capter encore plus de dollars de dépenses d’investissements qu’avec sa précédente génération » de puces.

Et il s’attend à ce que la multinationale « continue non seulement à dominer mais à creuser l’écart avec ses concurrents dans l’IA. »

En plus d’être dominant en matière de hardware (composants physiques) avec ses puces, Nvidia tire aussi son épingle du jeu sur les software (logiciels). « Tous les spécialistes IA utilisent principalement des librairies dont tout l’écosystème dépend de Nvidia.

(Cette entreprise) a aujourd’hui la capacité de conduire le développement software en fonction de ce qu’elle est en capacité de faire d’un point de vue hardware”, indique Raphaël-David Lasseri.

Outre sa nouvelle puce, la firme a présenté lundi un nouvel ensemble d’outils logiciels destinés à faciliter la vente de modèles d’IA par les développeurs aux entreprises exploitant la technologie du groupe. Une manière pour Nvidia de pérenniser son « quasi-monopole » pendant encore quelque temps.

france24