Google a présenté lundi Bard, sa première intelligence artificielle grand public. Mais sa première démonstration s’est avérée fausse.

Après Open AI, c’était au tour de Google de faire la présentation ce lundi de son chatbot Bard. Cette intelligence artificielle devrait devenir « plus largement accessible au public dans les semaines à venir » selon les mots de Google. Le service n’est en effet pas encore disponible, mais il a déjà son lot de détracteurs.

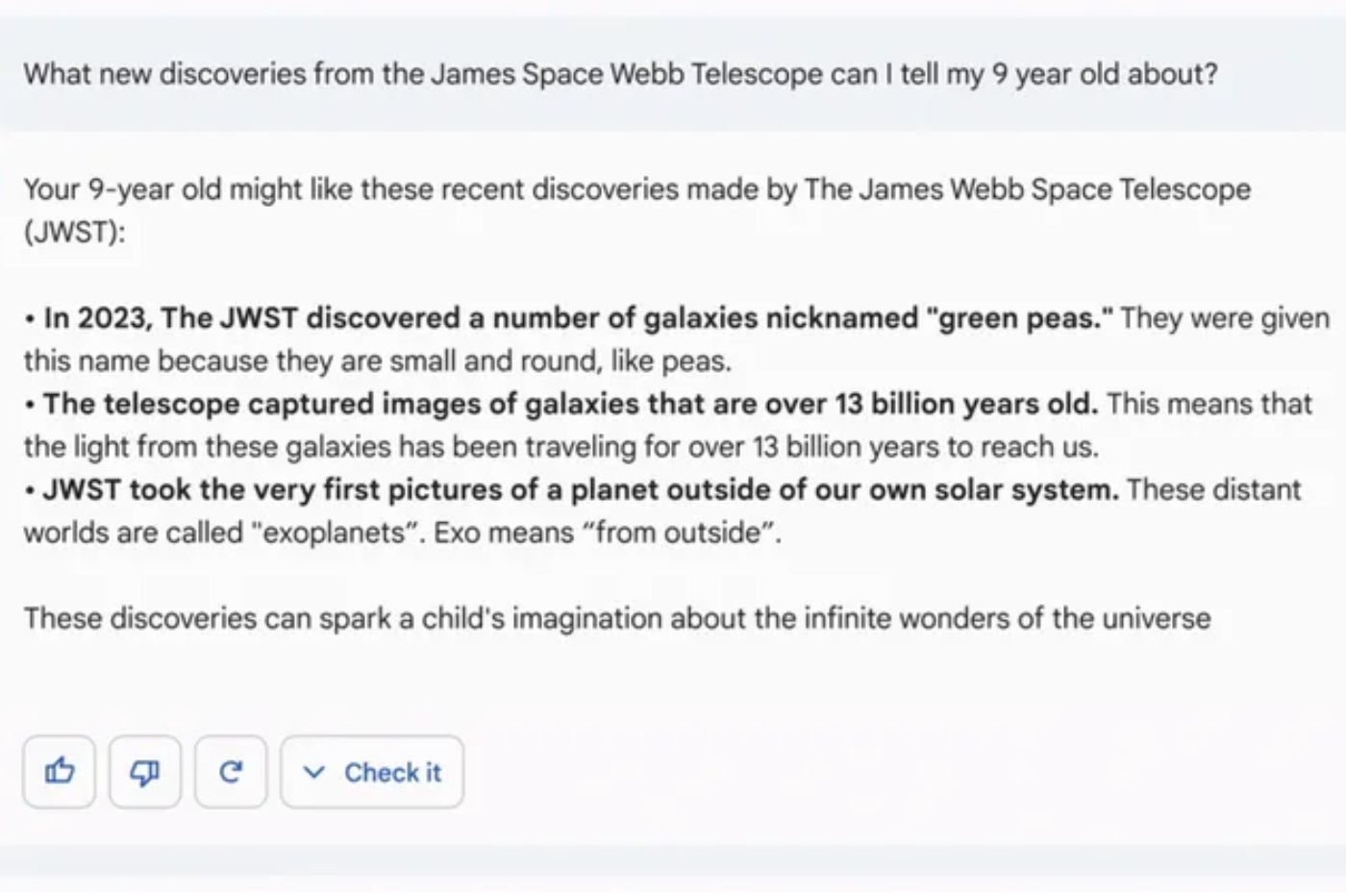

Dans une image partagée par Google pour faire la promotion de son service, et montrer la puissance de ce dernier, la question posée à Bard est la suivante : « Quelles nouvelles découvertes du télescope spatial James Webb puis-je parler à mon enfant de 9 ans ? » L’intelligence artificielle de Google répond alors avec trois propositions, dont une annonçant que le télescope James Webb a été le premier à prendre une photo d’une exoplanète (une planète en dehors du système solaire).

Cette réponse devait servir de base au plan de communication de Google pour son intelligence artificielle, mais Bard a commis son premier impair. En effet, comme l’ont rapidement fait remarquer de nombreux astronomes sur les réseaux sociaux, la toute première photographie d’une exoplanète n’est pas le fruit du travail de James Webb.

Le système « prédictif » des IA : le maillon faible ?

L’astrophysicien Grant Tremblay a notamment réagi sur Twitter. Il assure que cette erreur de communication montre également les limites de ces intelligences artificielles qui n’en sont qu’au début de leur développement. Dans un autre post sur le réseau social, il explique attendre avec impatience que ces IA soient capables de « corriger toute seule » comme les humains peuvent le faire en changeant d’avis et de réponse sur une question donnée.

Pour un professeur spécialisé dans la question des IA, c’est tout le système de saisie semi-automatique qui est à l’origine de ces nombreuses « hallucinations ». Dans le cas de Bard (mais aussi de ChatGPT), les informations ne sont pas piochées sur internet, mais dans un immense corpus de texte.

L’IA va analyser cette immense base de données afin d’en extraire des passages répondant à la question de l’utilisateur. Malheureusement la saisie semi-automatique essaye de deviner le mot qui va suivre, plutôt que de simplement agir à réaction. C’est cette volonté prédictive qui induit souvent les IA en erreur.

Se tromper, apprendre, corriger

En réaction à cette première erreur de Bard, Jane Park, porte-parole de Google a annoncé au média américain The Verge que la firme allait lancer un nouvel outil pour rendre les informations plus fiables à l’avenir. Baptisé Trusted Tester, cette fonctionnalité devrait combiner les commentaires externes des utilisateurs avec ceux déjà faits en interne par les développeurs derrière ce projet.

L’objectif est ainsi de repérer les erreurs commises par Bard et de comprendre d’où elles viennent. En arrivant à remonter à l’origine de ces problèmes, les ingénieurs de Google pourraient apporter un correctif à Bard et ainsi améliorer le système. Google, comme Microsoft, a annoncé que leur intelligence artificielle allait être utilisée dans leur moteur de recherche respectif.

the verge