Le modèle de langage GPT passe à la version 4. OpenAI a annoncé la nouvelle génération de son IA, dont la version 3.5 a donné ChatGPT. Elle serait beaucoup plus précise et nuancée, et multimodale. Une nouvelle version qui est toutefois réservée aux abonnés pour l’instant.

OpenAI, la firme derrière le fameux chatbot ChatGPT, vient d’annoncer la nouvelle version très attendue de son grand modèle de langage (LLM), GPT-4. Cette nouvelle version est d’ores et déjà disponible pour les abonnés ChatGPT Plus (à 20 dollars par mois), et les développeurs pourront s’inscrire sur liste d’attente pour accéder à la nouvelle API (interface de programmation).

La firme n’a pas dévoilé les détails techniques qui différencient GPT-4 de son prédécesseur. Toutefois, elle affirme que cette nouvelle IA « est plus fiable, plus créative et capable de traiter des instructions beaucoup plus nuancées que GPT-3.5 ». Là où ChatGPT est limité à 3 000 mots en entrée ou sortie, la nouvelle version peut atteindre 25 000 mots. De quoi donner des sueurs froides à ceux qui cherchent à reconnaître les contenus générés par IA.

Announcing GPT-4, a large multimodal model, with our best-ever results on capabilities and alignment: https://t.co/TwLFssyALF pic.twitter.com/lYWwPjZbSg

— OpenAI (@OpenAI) March 14, 2023

Une IA qui comprend les images en plus du texte

Contrairement à ce qu’avait indiqué Microsoft Allemagne la semaine dernière, GPT-4 ne prendra pas en charge les vidéos. Malgré tout, il s’agit bel et bien d’un modèle multimodal. L’IA accepte des images en entrée, en plus du texte, mais les réponses seront limitées au texte. Toutefois, la prise en charge des images ne sera pas accessible au grand public dans l’immédiat. Elle est actuellement testée par Be My Eyes, une application d’assistance pour personnes malvoyantes.

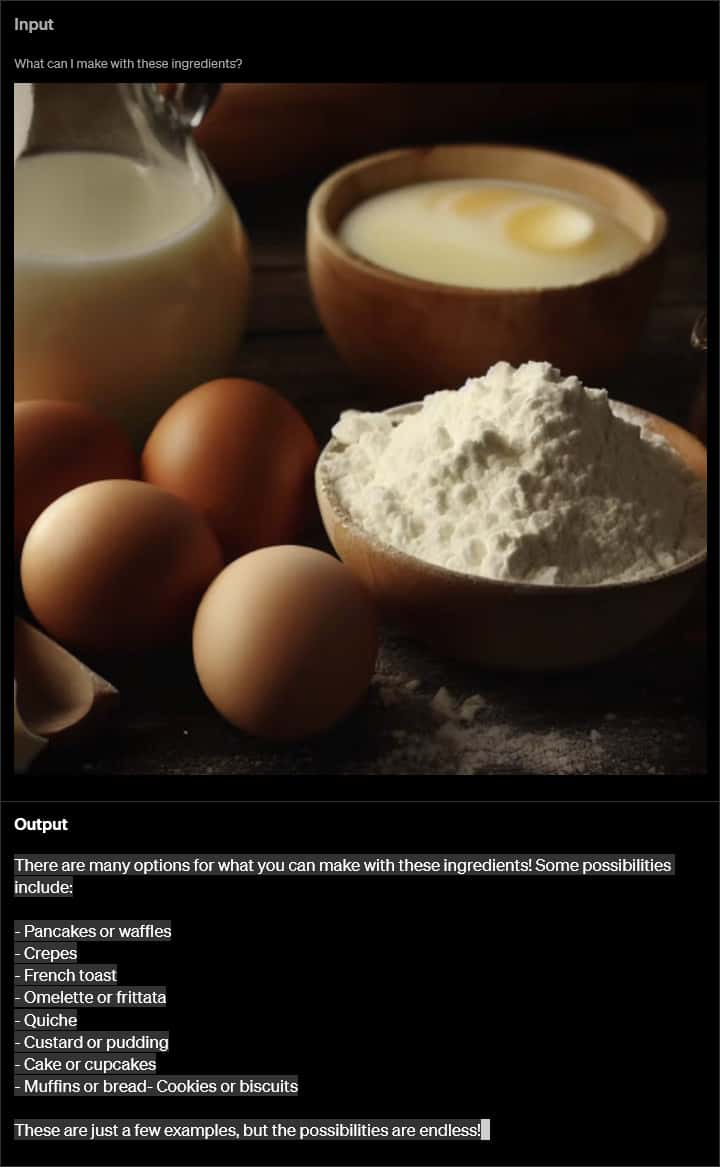

Même s’il faudra attendre pour pouvoir utiliser des images, les démonstrations de la version multimodale de GPT-4 sont impressionnantes. Lorsque l’IA est présentée avec une photo de ballons flottants attachés au sol par des fils, et la question « Que se passerait-il si les fils étaient coupés », elle est capable de comprendre le contenu de l’image et de répondre « Les ballons s’envoleraient ». Dans un autre exemple, GPT-4 répond à une photo de lait, œufs et farine avec des idées de recettes. Plus besoin de rester devant la porte ouverte du frigo en essayant de décider quoi préparer pour le dîner. Il suffira d’envoyer une photo à l’IA pour avoir des suggestions.

EXEMPLE DE REQUÊTE AVEC UNE IMAGE QUI MONTRE DES INGRÉDIENTS. GPT-4 LISTE DES RECETTES POSSIBLES. © OPENAI

Plus de bonnes réponses, moins d’hallucinations

OpenAI prévient que GPT-4 est toujours sujette aux hallucinations, mais que cette dernière version a tout de même moins tendance à se tromper. Le taux de bonnes réponses serait amélioré de 40 % par rapport à la version actuelle de ChatGPT, et le risque de répondre à des demandes de contenus non autorisés serait réduit de 82 %.

C’est une bonne nouvelle lorsque l’on sait que la firme a plusieurs partenariats commerciaux. Duolingo, l’application pour apprendre les langues, a annoncé son service Duolingo Max, des conversations avec GPT-4 en langue étrangère (actuellement limité au français et à l’espagnol pour les utilisateurs anglophones). Le système de paiement en ligne Stripe utilise GPT-4 pour le support technique et pour lutter contre la fraude.

We’re happy to confirm the new Bing is running on GPT-4, which we’ve customized for search.https://t.co/RVj26gJVQG

Try it out by joining the new Bing preview at https://t.co/tRrsjYDpfr. pic.twitter.com/zUCUbHa05U

— Yusuf Mehdi (@yusuf_i_mehdi) March 14, 2023

Ceux qui ont accès à la nouvelle version de Bing avec l’IA conversationnelle (après s’être inscrit sur liste d’attente) ont d’ailleurs déjà testé GPT-4. Après avoir évité de donner une réponse claire ces dernières semaines, Microsoft a enfin confirmé que son moteur de recherche intègre bel et bien le nouveau modèle de langage.

FUTURA