Les intelligences artificielles sont de plus en plus performantes, rendant difficile la reconnaissance entre les deux travaux.

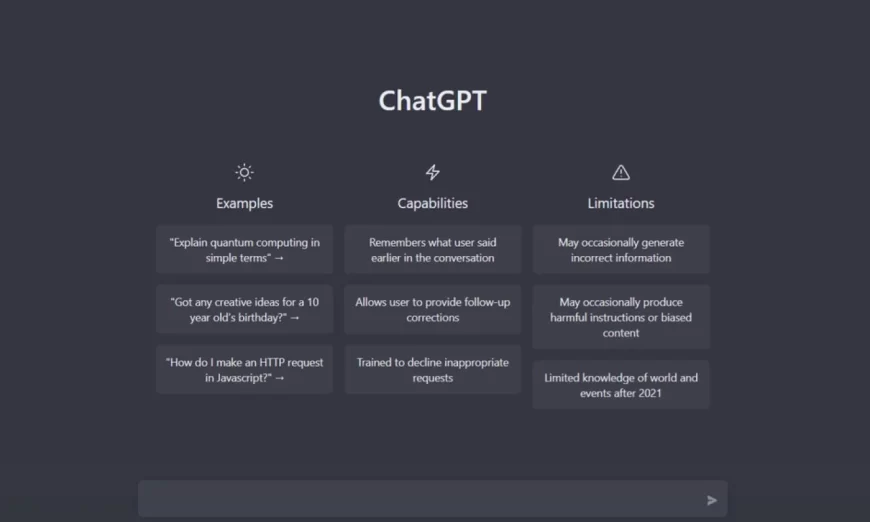

Depuis l’arrivée de ChatGPT ces dernières semaines, de nombreuses personnes utilisent l’intelligence artificielle d’Open AI pour produire des contenus variés. Des élèves font travailler l’IA pour ne pas faire leurs devoirs, des sites d’informations testent les fonctionnalités de ce nouveau service pour produire des articles. Si le résultat est très proche de ce que pourrait produire un humain, il existe cependant quelques petites nuances qui permettent de reconnaître un texte écrit par un robot.

Faire la différence entre un travail humain et une production “synthétique” demande quelques bons réflexes. Edward Tian étudiant dans la célèbre université de Princeton a ainsi mis au point GPTZero, un système capable de reconnaître l’origine d’un texte en fonction de sa “variance” et de sa “complexité”.

Il explique que le travail de l’IA est encore facilement reconnaissable. Elles sont capables de générer du texte mais ce dernier va être assez sobre dans la construction. Les changements de rythme sont rares, tout comme les variations dans la métrique des phrases. Un humain amènera plus de “variable” dans son texte en le construisant avec un modèle beaucoup plus complexe que celui de l’IA.

Mettre des « limites » à l’IA : une solution temporaire ?

Tom Goldstein, professeur d’informatique à l’Université du Maryland, rejoint cet avis, mais il est cependant assez pessimiste pour l’avenir. Selon lui les modèles de reconnaissance de l’IA vont devenir de moins en moins fiables à mesure que cette dernière s’améliore et se complexifie. Il rappelle que l’objectif des entreprises comme Open AI est de rendre le texte “synthétique” aussi vrai que nature.

Afin de conserver une limite claire entre l’IA et les textes humains, il propose dans un récent article de mettre en place des filigranes, des barrières qui limiteraient le travail de l’intelligence artificielle. L’idée est aujourd’hui partagée par une grande partie de la communauté scientifique, mais plusieurs voix assurent que ce système ne sera pas suffisant.

« Signer » les créations humaines pour empêcher la copie

Micah Musser, chercheur au sein de l’université de Georgetown, fait partie de ces réfractaires. Pour lui, la mise en place de filigrane, d’une “ligne rouge” sera tôt ou tard violé par des modèles d’intelligence artificielle plus complexe. De façon intentionnelle ou non. Le scientifique propose plutôt une approche similaire à ce qui se fait pour les images.

Le groupe Meta utilise cette méthode depuis 2020. Elle permet de reconnaître les images modifiées ou créées par l’IA grâce à des « poisons » introduits dans les métadonnées de ces dernières. Le système de détection va partir à la recherche de ces données, si elles ont été altérées par rapport à leur forme de départ, c’est le signe d’une utilisation de l’intelligence artificielle pour une modification ou une création de l’œuvre.

Ce système fonctionne aujourd’hui très bien sur les images et les vidéos afin de reconnaître les créations synthétiques, mais d’autres chercheurs, dont Goldstein craignent que les textes ne bénéficient pas d’assez d’éléments pour pouvoir “dissimuler” ces “poisons”.

wired